Es ist bekannt, dass Apple die Vertraulichkeit der Daten, die die Geräte im Ökosystem durchlaufen, sehr hält und dass sie durch die Augen der Neugierigen sehr gut geschützt sind. Dies bedeutet jedoch nicht, dass Benutzer keine Regeln im Zusammenhang mit Ethik, Moral und warum nicht, der Menschheit.

Apple hat angekündigt, bald eine Technologie zu starten, die alle von Benutzern gespeicherten Bilder in der Lage ist iCloud und identifizieren Fotos, die sexuellen Missbrauch gegen Kinder enthalten. Sexuelles Kindesmissbrauchsmaterial (CSAM).

Diese Technologie wird von Apple gegen Ende dieses Jahres, höchstwahrscheinlich in einer Pilotversion, für eine kleine Anzahl von Benutzern auf den Markt gebracht.

Wenn Sie fragen: "Wo ist die Vertraulichkeit der Daten?", Finden Sie heraus, dass alles, was wir Inhalte erhalten Video / Foto Dies geschieht durch ein verschlüsseltes Protokoll. Neben der Speicherung von Daten in iCloud wird verschlüsselt, aber die Anbieter solcher Dienste haben den Datenverschlüsselungsschlüssel. Hier sagen wir nicht nur Apple. Microsoft, Google und andere Cloud -Speicherdienste tun dasselbe.

Die gespeicherten Daten können entschlüsselt und überprüft werden, wenn sie in einer rechtlichen Schritten angefordert werden oder ob es sich um die Gesetze verstößt. Wie diejenigen, die Gewalt gegen Kinder und Frauen betreffen.

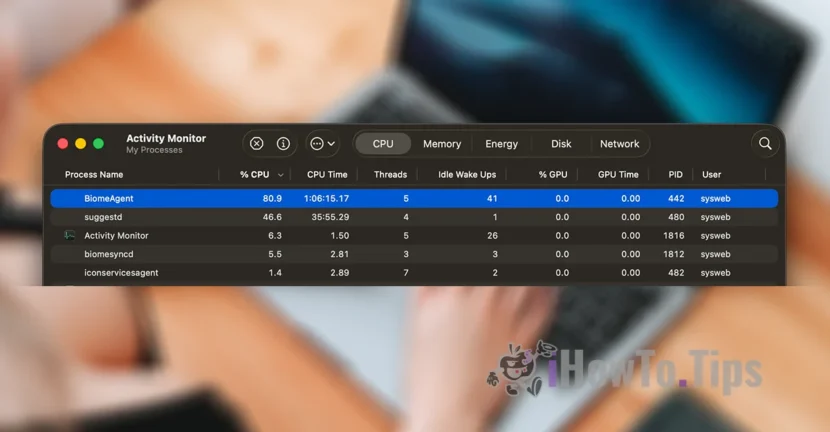

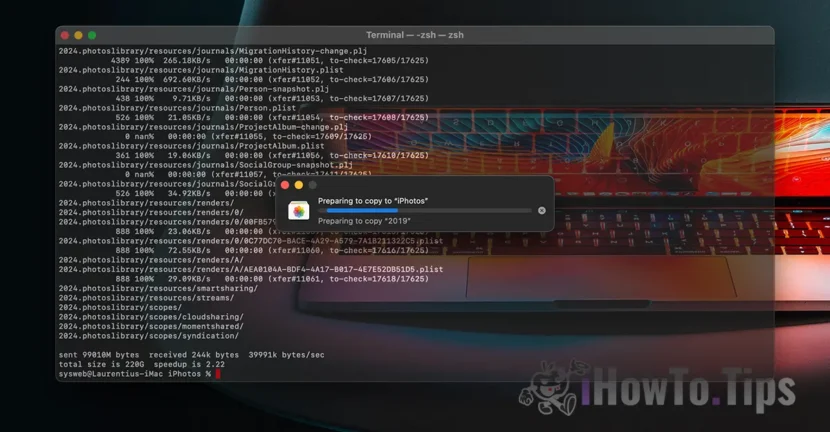

Um die Vertraulichkeit von Nutzern zu behalten, basiert das Unternehmen auf einer neuen Technologie mit dem Namen NeuralHash, die die Fotos in iCloud scannt und diejenigen identifiziert, die Gewalt gegen Kinder enthalten, indem sie sie mit anderen Bildern aus einer Datenbank vergleichen.

Es ähnelt etwas Gesichtserkennung oder intelligenter Erkennung von Objekten, Tieren und anderen Elementen.

Die Technologie kann die Bilder scannen und überprüfen, die über ein iPhone-, iPad- oder Mac -Gerät gemacht oder übertragen werden, selbst wenn sie Änderungen unterzogen werden.