Είναι γνωστό ότι η Apple νοιάζεται πολύ για το απόρρητο των δεδομένων που περνούν από τις συσκευές στο οικοσύστημα και ότι προστατεύονται καλά από τα αδιάκριτα βλέμματα. Ωστόσο, αυτό δεν σημαίνει ότι οι χρήστες δεν χρειάζεται να υπακούουν σε κανόνες που σχετίζονται με την ηθική, την ηθική και γιατί όχι, την ανθρωπιά.

Η Apple ανακοίνωσε ότι θα κυκλοφορήσει σύντομα μια τεχνολογία ικανή να σαρώνει όλες τις εικόνες που είναι αποθηκευμένες από τους χρήστες στο iCloud και να εντοπίσετε φωτογραφίες που περιέχουν σεξουαλική κακοποίηση παιδιών. Υλικό σεξουαλικής κακοποίησης παιδιών (CSAM).

Αυτή η τεχνολογία θα κυκλοφορήσει από την Apple προς το τέλος του τρέχοντος έτους, πιθανότατα σε πιλοτική έκδοση, για περιορισμένο αριθμό χρηστών.

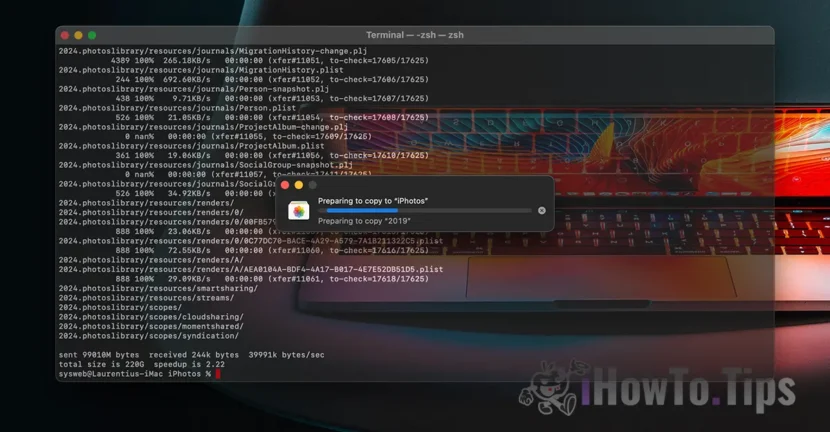

Αν αναρωτηθείτε «πού είναι το απόρρητο των δεδομένων;», ανακαλύψτε ότι όλα όσα λαμβάνουμε είναι περιεχόμενο βίντεο/φωτογραφίες γίνεται μέσω κρυπτογραφημένου πρωτοκόλλου. Με τον ίδιο τρόπο, η αποθήκευση δεδομένων στο iCloud είναι κρυπτογραφημένη, αλλά οι πάροχοι τέτοιων υπηρεσιών διατηρούν το κλειδί κρυπτογράφησης δεδομένων. Εδώ δεν μιλάμε μόνο για την Apple. Η Microsoft, η Google και άλλες υπηρεσίες αποθήκευσης δεδομένων cloud κάνουν το ίδιο.

Τα αποθηκευμένα δεδομένα μπορούν να αποκρυπτογραφηθούν και να επαληθευτούν εάν ζητηθούν σε δικαστική ενέργεια ή εάν παραβιάζουν κατάφωρα τους νόμους. Όπως αυτές που αφορούν πράξεις βίας κατά παιδιών και γυναικών.

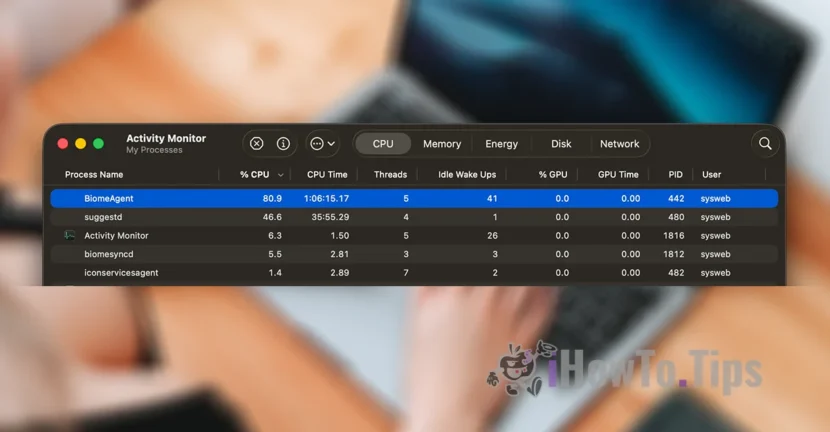

Για να διατηρήσει το απόρρητο των χρηστών, η εταιρεία βασίζεται σε μια νέα τεχνολογία, που ονομάζεται NeuralHash, η οποία θα σαρώνει φωτογραφίες iCloud και θα εντοπίζει αυτές που περιέχουν βία κατά των παιδιών, συγκρίνοντάς τις με άλλες εικόνες σε μια βάση δεδομένων.

Είναι κάπως παρόμοιο με την αναγνώριση προσώπου ή την έξυπνη αναγνώριση αντικειμένων, ζώων και άλλων στοιχείων.

Η τεχνολογία θα μπορεί να σαρώνει και να επαληθεύει τις φωτογραφίες που λαμβάνονται ή μεταφέρονται μέσω μιας συσκευής iPhone, iPad ή Mac, ακόμα κι αν αυτές υποστούν αλλαγές.