Известно е, че Apple много държи на поверителността на данните, които преминават през устройствата в екосистемата и те са добре защитени от любопитни очи. Това обаче не означава, че потребителите не трябва да спазват правила, свързани с етиката, морала и защо не, хуманността.

Apple обяви, че скоро ще пусне технология, способна да сканира всички изображения, съхранявани от потребителите в iCloud и идентифицирайте снимки, които съдържат сексуално насилие срещу деца. Материали със сексуално малтретиране на деца (CSAM).

Тази технология ще бъде пусната от Apple към края на тази година, най-вероятно в пилотна версия, за ограничен брой потребители.

Ако се запитате "къде е поверителността на данните?", разберете, че всичко, което получаваме, е съдържание видеоклипове/снимки става чрез криптиран протокол. По същия начин съхранението на данни в iCloud е криптирано, но доставчиците на такива услуги държат ключа за криптиране на данните. Тук не говорим само за Apple. Microsoft, Google и други облачни услуги за съхранение на данни правят същото.

Съхранените данни могат да бъдат декриптирани и проверени, ако са поискани в съдебно дело или ако грубо нарушават законите. Като например тези относно актове на насилие срещу деца и жени.

За да запази поверителността на потребителите, компанията разчита на нова технология, наречена NeuralHash, която ще сканира iCloud снимки и ще идентифицира тези, които съдържат насилие срещу деца, като ги сравнява с други изображения в база данни.

Подобно е донякъде на лицевото разпознаване или интелигентното разпознаване на обекти, животни и други елементи.

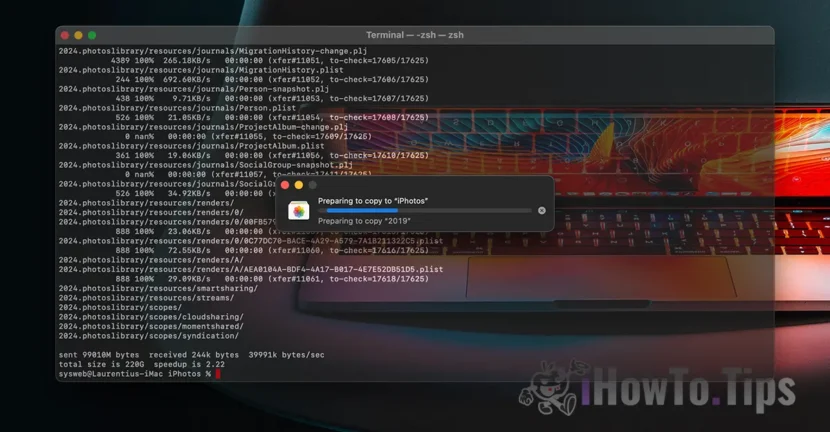

Технологията ще може да сканира и проверява снимките, които са направени или прехвърлени през iPhone, iPad или Mac устройство, дори ако те ще претърпят промени.