ومن المعروف أن شركة آبل تهتم كثيراً بسرية البيانات التي تمر عبر الأجهزة الموجودة في النظام البيئي وأنها محمية بشكل جيد من أعين المتطفلين. ومع ذلك، هذا لا يعني أنه لا يتعين على المستخدمين الالتزام بالقواعد المتعلقة بالأخلاق والأخلاق ولماذا لا، الإنسانية.

أعلنت شركة Apple أنها ستطلق قريبًا تقنية قادرة على مسح جميع الصور المخزنة بواسطة المستخدمين في [ايكلوود] وتحديد الصور التي تحتوي على اعتداءات جنسية على الأطفال. مواد الاعتداء الجنسي على الأطفال (CSAM).

ومن المقرر أن تطلق شركة آبل هذه التقنية في نهاية هذا العام، على الأرجح في نسخة تجريبية، لعدد محدود من المستخدمين.

إذا سألت نفسك "أين سرية البيانات؟"، فاكتشف أن كل ما نتلقاه هو مضمون أشرطة الفيديو / الصور ويتم ذلك من خلال بروتوكول مشفر. وبالمثل، يتم تشفير تخزين البيانات في iCloud، لكن مقدمي هذه الخدمات يحتفظون بمفتاح تشفير البيانات. نحن هنا لا نتحدث فقط عن شركة أبل. تفعل Microsoft وGoogle وخدمات تخزين البيانات السحابية الأخرى نفس الشيء.

يمكن فك تشفير البيانات المخزنة والتحقق منها إذا تم طلبها في إجراء قانوني أو إذا كانت تنتهك القوانين بشكل صارخ. مثل تلك المتعلقة بأعمال العنف ضد الأطفال والنساء.

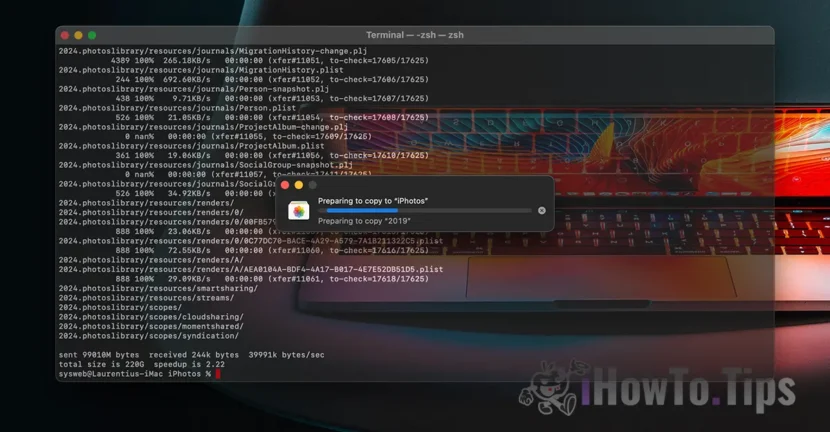

وللحفاظ على خصوصية المستخدم، تعتمد الشركة على تقنية جديدة تسمى NeuralHash، والتي ستقوم بمسح صور iCloud وتحديد تلك التي تحتوي على عنف ضد الأطفال، من خلال مقارنتها بصور أخرى في قاعدة بيانات.

وهو يشبه إلى حد ما التعرف على الوجه أو التعرف الذكي على الأشياء والحيوانات والعناصر الأخرى.

وستكون التقنية قادرة على مسح الصور التي تم التقاطها أو نقلها عبر جهاز iPhone أو iPad أو Mac والتحقق منها، حتى لو كانت ستخضع لتغييرات.