Det är känt att Apple varar mycket till konfidentialiteten i de data som passerar genom enheterna i ekosystemet och att de är mycket väl skyddade av de nyfikna ögonen. Det betyder dock inte att användare inte behöver följa regler relaterade till etik, moral och varför inte, mänskligheten.

Apple har meddelat att det snart kommer att lansera en teknik som kan skanna alla bilder som lagras av användare i iCloud och identifiera foton som innehåller sexuella övergrepp mot barn. Sexuellt missbruksmaterial (CSAM).

Denna teknik kommer att lanseras av Apple i slutet av detta år, troligen i en pilotversion, för ett litet antal användare.

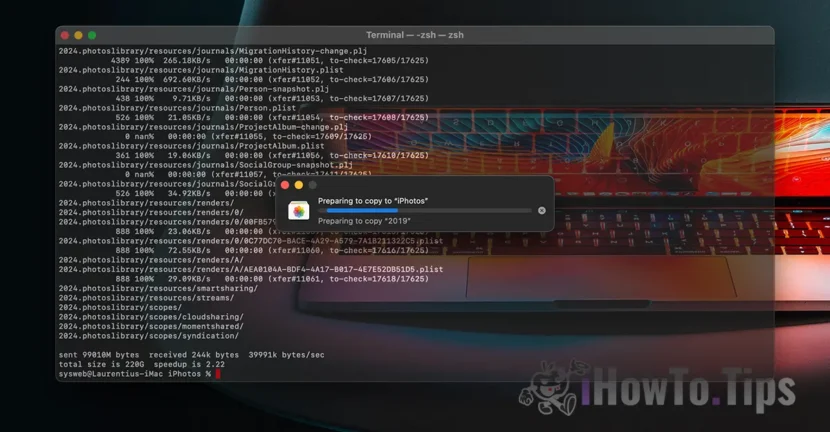

Om du frågar "Var är informationens konfidentialitet?", Ta reda på att allt vi får innehåll video / foto Det görs genom ett krypterat protokoll. Förutom lagring av data i iCloud görs krypterad, men leverantörerna av sådana tjänster har datakrypteringsnyckeln. Här säger vi inte bara Apple. Microsoft, Google och andra molnlagringstjänster gör samma sak.

De lagrade uppgifterna kan dekrypteras och kontrolleras om de begärs i en rättslig åtgärd eller om den flagrant bryter mot lagar. Till exempel de som rör fakta om våld mot barn och kvinnor.

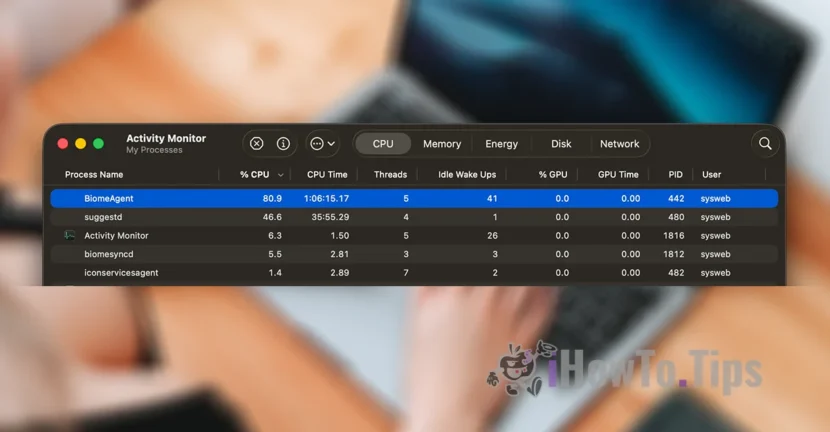

För att behålla användarnas sekretess är företaget baserat på en ny teknik, kallad NeuralHash, som kommer att skanna fotona i iCloud och identifiera de som innehåller våld mot barn genom att jämföra dem med andra bilder från en databas.

Det är något liknande ansiktsigenkänning eller intelligent erkännande av föremål, djur och andra element.

Tekniken kommer att kunna skanna och kontrollera bilderna som görs eller överföras via en iPhone, iPad eller Mac -enhet, även om de kommer att genomgå ändringar.