Il est connu qu'Apple dure beaucoup à la confidentialité des données qui traversent les appareils de l'écosystème et qu'ils sont très bien protégés par les yeux du curieux. Cependant, cela ne signifie pas que les utilisateurs n'ont pas à obéir aux règles liées à l'éthique, à la morale et pourquoi pas l'humanité.

Apple a annoncé qu'il lancera bientôt une technologie capable de scanner toutes les images stockées par les utilisateurs iCloud et identifier des photos qui contiennent des abus sexuels contre les enfants. Matériel de maltraitance des enfants sexuels (CSAM).

Cette technologie sera lancée par Apple vers la fin de cette année, probablement dans une version pilote, pour un petit nombre d'utilisateurs.

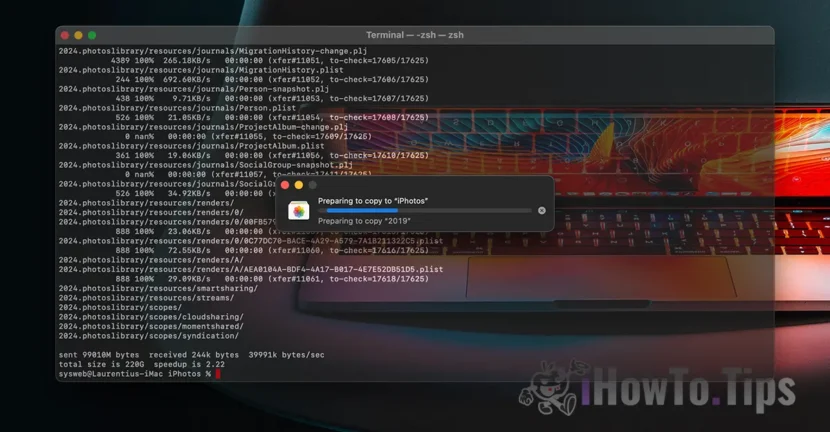

Si vous demandez "Où est la confidentialité des données?", Découvrez que tout ce que nous recevons contenait vidéo / photo Cela se fait à travers un protocole crypté. Ainsi que le stockage des données dans iCloud est rendu chiffré, mais les fournisseurs de ces services ont la clé de chiffrement des données. Ici, nous disons non seulement Apple. Microsoft, Google et d'autres services de stockage cloud font de même.

Les données stockées peuvent être décryptées et vérifiées si elles sont demandées dans une action en justice ou si elles violent une manière flagrante les lois. Comme ceux concernant les faits de violence contre les enfants et les femmes.

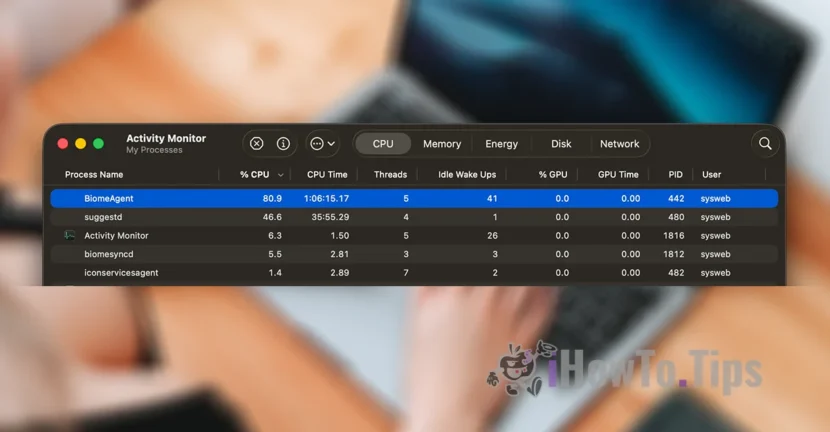

Pour maintenir la confidentialité des utilisateurs, la société est basée sur une nouvelle technologie, appelée Neuralhash, qui analysera les photos dans iCloud et identifiera celles qui contiennent de la violence contre les enfants, en les comparant à d'autres images d'une base de données.

Il est quelque peu similaire à la reconnaissance faciale ou à la reconnaissance intelligente des objets, des animaux et d'autres éléments.

La technologie pourra numériser et vérifier les images qui sont réalisées ou transférées via un appareil iPhone, iPad ou Mac, même s'ils subiront des modifications.