Wiadomo, że Apple bardzo dba o poufność danych, które przechodzą przez urządzenia w ekosystemie i aby były one dobrze chronione przed wzrokiem ciekawskich. Nie oznacza to jednak, że użytkownicy nie muszą przestrzegać zasad związanych z etyką, moralnością i, dlaczego nie, człowieczeństwem.

Firma Apple ogłosiła, że wkrótce wypuści technologię zdolną do skanowania wszystkich obrazów przechowywanych przez użytkowników w iCloud i identyfikuj zdjęcia przedstawiające wykorzystywanie seksualne dzieci. Materiały przedstawiające wykorzystywanie seksualne dzieci (CSAM).

Technologia ta zostanie wdrożona przez Apple pod koniec tego roku, najprawdopodobniej w wersji pilotażowej, dla ograniczonej liczby użytkowników.

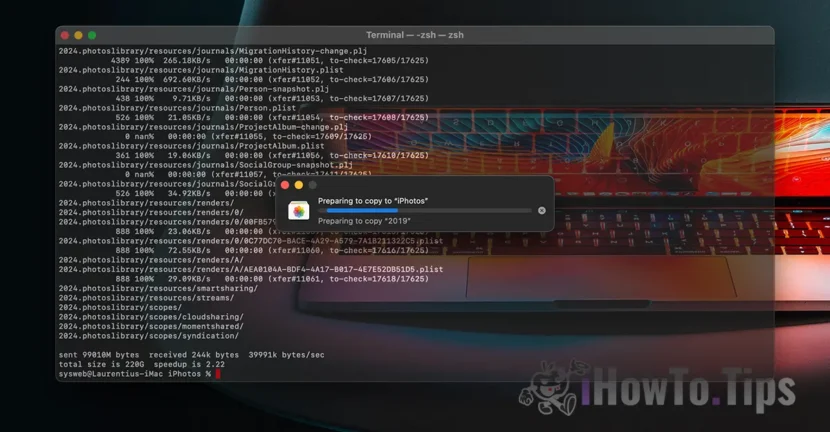

Jeśli zadajesz sobie pytanie „gdzie jest poufność danych?”, przekonaj się, że wszystko, co otrzymujemy, jest treściwe filmy/zdjęcia odbywa się to poprzez szyfrowany protokół. W ten sam sposób szyfrowane są dane przechowywane w iCloud, jednak dostawcy takich usług posiadają klucz szyfrowania danych. Tutaj nie mówimy tylko o Apple. Microsoft, Google i inne usługi przechowywania danych w chmurze robią to samo.

Przechowywane dane można odszyfrować i zweryfikować, jeśli zostaną o to poproszone w ramach czynności prawnej lub jeśli rażąco naruszają prawo. Na przykład te dotyczące aktów przemocy wobec dzieci i kobiet.

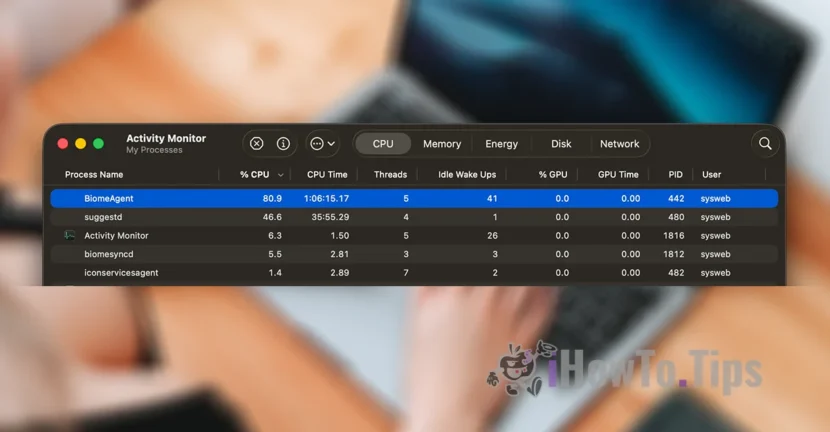

Aby chronić prywatność użytkowników, firma wykorzystuje nową technologię o nazwie NeuralHash, która skanuje zdjęcia iCloud i identyfikuje te, które zawierają przemoc wobec dzieci, porównując je z innymi obrazami w bazie danych.

Przypomina to trochę rozpoznawanie twarzy, czyli inteligentne rozpoznawanie obiektów, zwierząt i innych elementów.

Technologia będzie w stanie skanować i weryfikować zdjęcia robione lub przesyłane za pomocą iPhone'a, iPada lub urządzenia Mac, nawet jeśli ulegną one zmianom.