Het is bekend dat Apple veel waarde hecht aan de vertrouwelijkheid van de gegevens die door de apparaten in het ecosysteem gaan en dat deze goed beschermd zijn tegen nieuwsgierige blikken. Dit betekent echter niet dat gebruikers zich niet hoeven te houden aan regels die verband houden met ethiek, moraliteit en waarom ook niet, de mensheid.

Apple heeft aangekondigd dat het binnenkort een technologie zal uitbrengen die alle afbeeldingen kan scannen die zijn opgeslagen door gebruikers in de icloud en foto's identificeren die seksueel misbruik tegen kinderen bevatten. Materiaal over seksueel misbruik van kinderen (CSAM).

Deze technologie wordt eind dit jaar door Apple gelanceerd, hoogstwaarschijnlijk in een pilotversie, voor een beperkt aantal gebruikers.

Als u zich afvraagt "waar is de vertrouwelijkheid van de gegevens?", Ontdek dan dat alles wat we ontvangen inhoud is video's/foto's het gebeurt via een gecodeerd protocol. Op dezelfde manier wordt de gegevensopslag in iCloud versleuteld, maar de aanbieders van dergelijke diensten beschikken over de gegevensversleutelingssleutel. Hier hebben we het niet alleen over Apple. Microsoft, Google en andere clouddiensten voor gegevensopslag doen hetzelfde.

De opgeslagen gegevens kunnen worden gedecodeerd en geverifieerd als hierom wordt gevraagd in het kader van een juridische actie of als ze op flagrante wijze de wet overtreden. Zoals die over gewelddaden tegen kinderen en vrouwen.

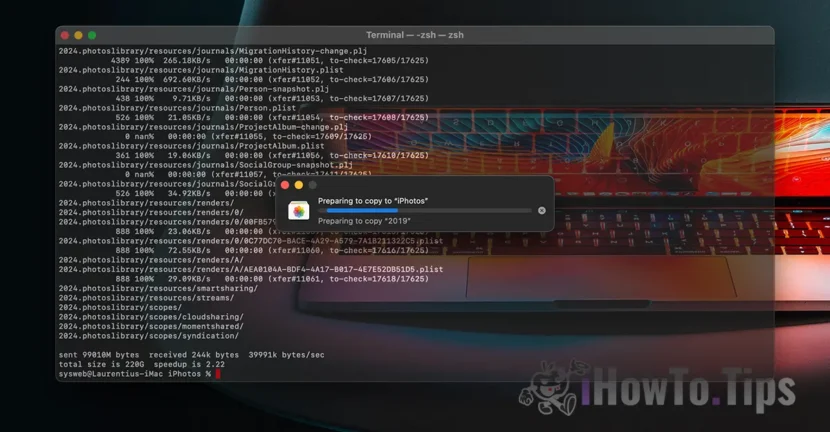

Om de privacy van gebruikers te beschermen, vertrouwt het bedrijf op een nieuwe technologie, NeuralHash genaamd, die iCloud-foto's zal scannen en de foto's zal identificeren die geweld tegen kinderen bevatten, door ze te vergelijken met andere afbeeldingen in een database.

Het lijkt enigszins op gezichtsherkenning of intelligente herkenning van objecten, dieren en andere elementen.

De technologie zal de foto's die zijn gemaakt of overgedragen via een iPhone, iPad of Mac-apparaat kunnen scannen en verifiëren, zelfs als ze wijzigingen zullen ondergaan.