Apple은 생태계의 장치를 통과하는 데이터의 기밀성에 많은 시간을 보내고 호기심의 눈에 의해 매우 잘 보호된다는 것이 알려져 있습니다. 그러나 사용자가 윤리, 도덕 및 인류와 관련된 규칙에 순종 할 필요가 없다는 것을 의미하지는 않습니다.

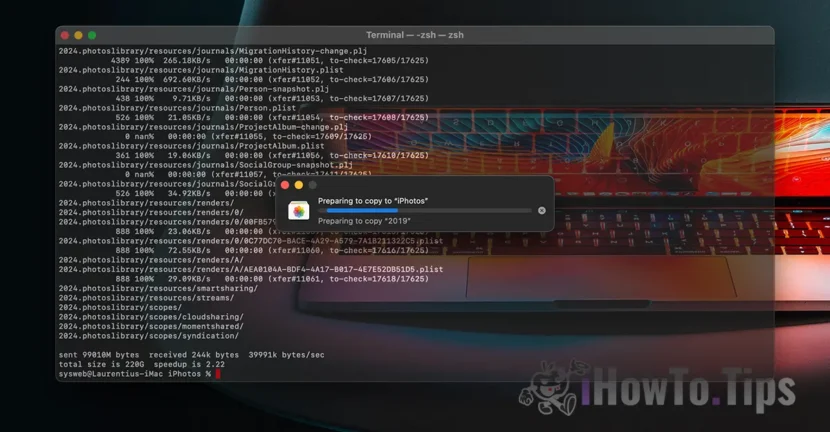

Apple은 곧 사용자가 저장 한 모든 이미지를 스캔 할 수있는 기술을 곧 출시 할 것이라고 발표했습니다. icloud 어린이에 대한 성적 학대가 포함 된 사진을 식별하십시오. 성 아동 학대 자료 (CSAM).

이 기술은 올해 말에 Apple이 소수의 사용자를 위해 파일럿 버전에서 출시 될 예정입니다.

"데이터의 기밀성은 어디에 있습니까?"라고 묻는다면, 우리가받는 모든 내용을 알아보십시오. 비디오 / 사진 암호화 된 프로토콜을 통해 수행됩니다. 뿐만 아니라 iCloud의 데이터 저장은 암호화되지만 해당 서비스의 제공 업체는 데이터 암호화 키를 가지고 있습니다. 여기서 우리는 애플뿐만 아니라. Microsoft, Google 및 기타 클라우드 스토리지 서비스도 마찬가지입니다.

저장된 데이터는 합법적 인 조치로 요청 된 경우 또는 법률을 위반하는 경우 해독하고 확인할 수 있습니다. 어린이와 여성에 대한 폭력의 사실에 관한 것과 같은.

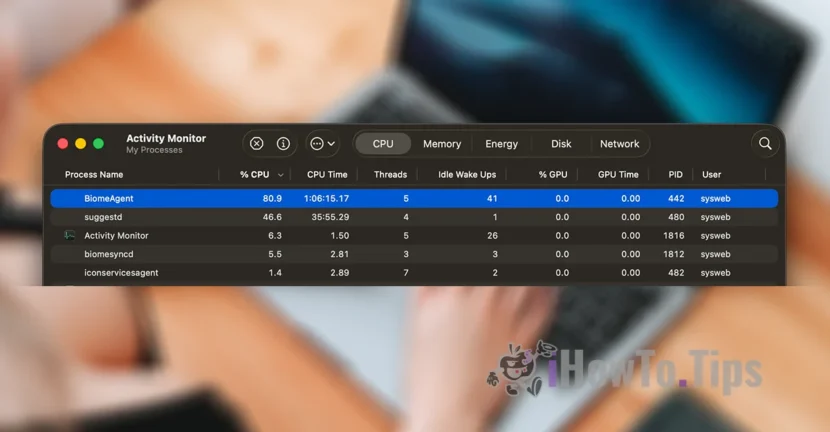

사용자의 기밀성을 유지하기 위해이 회사는 Neuralhash라는 새로운 기술을 기반으로합니다. Neuralhash는 iCloud에서 사진을 스캔하고 데이터베이스의 다른 이미지와 비교하여 어린이에 대한 폭력을 포함하는 사진을 식별합니다.

그것은 물체, 동물 및 기타 요소의 얼굴 인식 또는 지능적 인식과 다소 유사합니다.

이 기술은 iPhone, iPad 또는 Mac 장치를 통해 만들어 지거나 전송 된 사진을 변경하더라도 스캔하고 확인할 수 있습니다.