众所周知,苹果非常关心生态系统中设备传输的数据的机密性,并保护它们免受窥探。然而,这并不意味着用户不必遵守与伦理、道德甚至人性相关的规则。

苹果公司宣布将很快发布一项技术,能够扫描用户存储在电脑中的所有图像。 icloud 并识别包含针对儿童的性虐待的照片。儿童性虐待材料 (CSAM)。

苹果将于今年年底推出这项技术,很可能是针对有限数量的用户的试点版本。

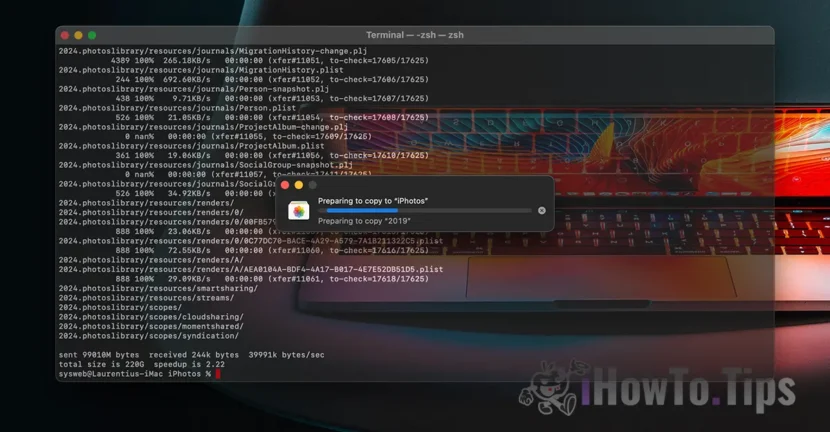

如果您问自己“数据的机密性在哪里?”,就会发现我们收到的所有内容都是内容 视频 /照片 它是通过加密协议完成的。以及在iCloud中的数据存储也已加密,但是此类服务的提供商具有数据加密密钥。在这里,我们不仅说苹果。 Microsoft,Google和其他云存储服务也是如此。

如果要求在法律诉讼中要求,可以解密并检查存储的数据,或者是否违反了法律。例如关于针对儿童和妇女的暴力事实的事实。

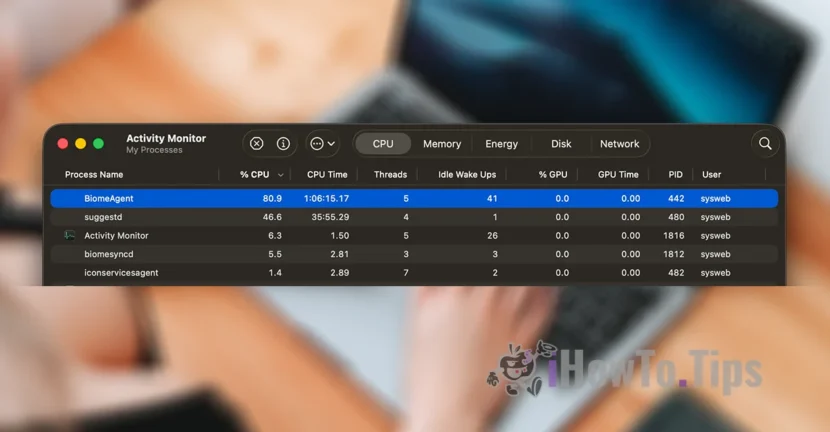

为了保持用户的机密性,该公司基于一种称为Neuralhash的新技术,该技术将在iCloud中扫描照片,并通过将其与数据库中的其他图像进行比较,并确定那些包含暴力的人。

它有点类似于面部识别或者物体、动物等元素的智能识别。

该技术将能够扫描和验证通过 iPhone、iPad 或 Mac 设备拍摄或传输的照片,即使它们会发生变化。