È noto che Apple tiene molto alla riservatezza dei dati che transitano attraverso i dispositivi dell'ecosistema e che questi siano ben protetti da occhi indiscreti. Ciò non significa però che gli utenti non debbano obbedire a regole legate all’etica, alla moralità e, perché no, all’umanità.

Apple ha annunciato che presto rilascerà una tecnologia in grado di scansionare tutte le immagini archiviate dagli utenti nel iCloud e identificare le foto che contengono abusi sessuali contro i bambini. Materiale relativo ad abusi sessuali su minori (CSAM).

Questa tecnologia verrà lanciata da Apple verso la fine di quest'anno, molto probabilmente in una versione pilota, per un numero limitato di utenti.

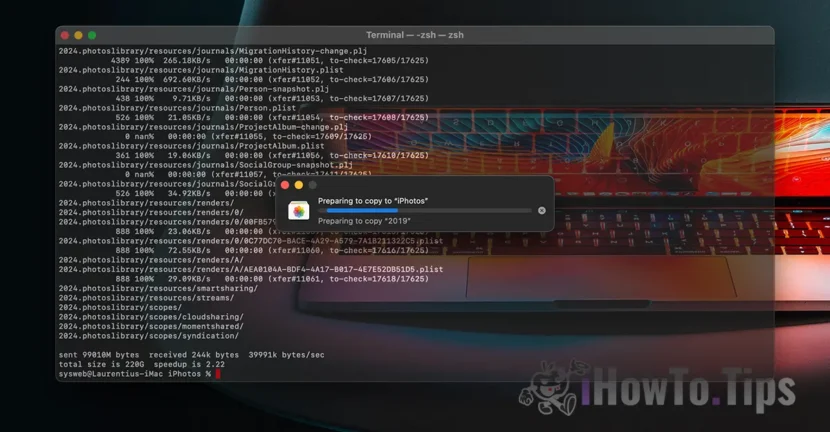

Se ti chiedi "dov'è la riservatezza dei dati?", scopri che tutto ciò che riceviamo è contenuto video/foto avviene attraverso un protocollo crittografato. Allo stesso modo, l'archiviazione dei dati su iCloud è crittografata, ma i fornitori di tali servizi detengono la chiave di crittografia dei dati. Qui non parliamo solo di Apple. Microsoft, Google e altri servizi di archiviazione dati cloud fanno lo stesso.

I dati memorizzati possono essere decrittografati e verificati se vengono richiesti in un'azione legale o se violano palesemente le leggi. Come quelle riguardanti gli atti di violenza contro i bambini e le donne.

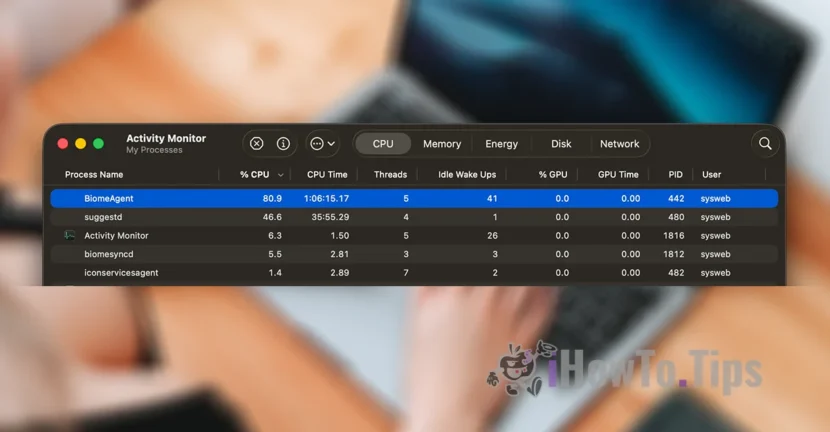

Per preservare la privacy degli utenti, l'azienda si affida a una nuova tecnologia, chiamata NeuralHash, che scansionerà le foto di iCloud e identificherà quelle che contengono violenza contro i bambini, confrontandole con altre immagini in un database.

È in qualche modo simile al riconoscimento facciale o al riconoscimento intelligente di oggetti, animali e altri elementi.

La tecnologia sarà in grado di scansionare e verificare le foto scattate o trasferite tramite un dispositivo iPhone, iPad o Mac, anche se subiranno modifiche.