Se stie ca Apple tine foarte mult la confidentialitatea datelor ce trec prin device-urile din ecosistem si ca acestea sunt ferite foarte bine de ochii curiosilor. Cu toate acestea nu inseamna ca utilizatorii nu trebuie sa se supuna unor reguli ce tin de etica, morala si de ce nu, de umanitate.

Apple a anuntat ca va lansa in curand o tehnologie capabila sa scaneze toate imaginile stocate de utilizatori in iCloud si de indentifice fotografiile ce contin abuz sexual impotriva copiilor. Child Sexual Abuse Material (CSAM).

Aceasta tehnologie va fi lansata de Apple spre finalul acestui an, cel mai probabil intr-o versiune pilot, pentru un numar restrans de utilizatori.

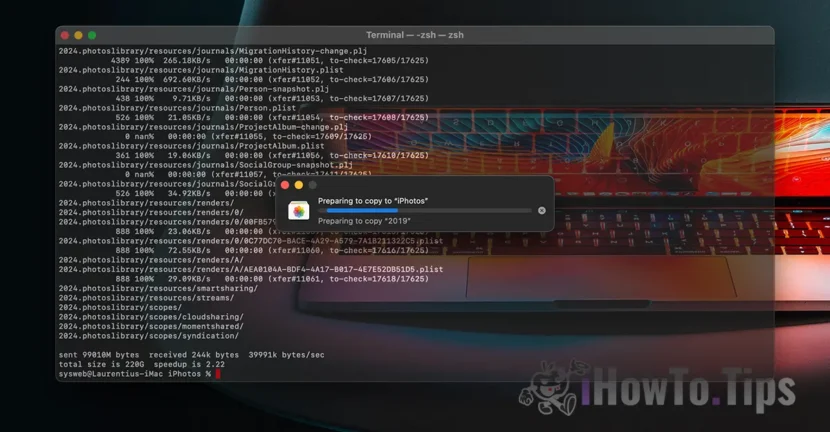

Daca va intrebati „unde mai este confidentialitatea datelor?”, aflati ca tot ce primim continut video / foto se face printr-un protocol criptat. La fel si stocarea datelor in iCloud este facuta criptat, insa providerii de astfel de servicii detin cheia de criptare a datelor. Aici spunem nu numai de Apple. Microsoft, Google si alte servicii de stocare date in cloud fac acelasi lucru.

Datele stocate pot fi decriptate si verificate daca sunt solicitate intr-o actiune legala sau daca incalca flagrant legi. Cum ar fi cele care privesc fapte de violenta impotriva copiilor si a femeilor.

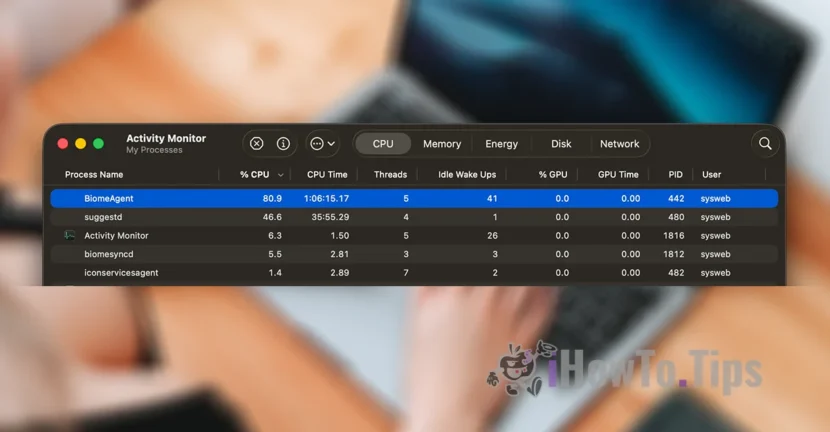

Pentru a pastra confidentialitatea utilizatorilor, compania se bazeaza pe o noua tehnologie, numita NeuralHash, care va scana fotografiile din iCloud si le va identifica pe cele care contin violenta impotriva copiilor, prin compararea lor cu alte imagini dintr-o baza de date.

Este oarecum ceva similar cu recunoastea faciala sau cu recunoasterea inteligenta a obiectelor, animalelor si a altor elemente.

Tehnologia va fi capabila sa scaneze si sa verifice pozele care sunt facute sau transferate printr-un device iPhone, iPad sau Mac, chiar daca ele vor suferi modificari.