Poznato je da Apple jako brine o povjerljivosti podataka koji prolaze kroz uređaje u ekosustavu te da su dobro zaštićeni od znatiželjnih pogleda. Međutim, to ne znači da korisnici ne moraju poštovati pravila vezana uz etiku, moralnost i zašto ne, humanost.

Apple je najavio da će uskoro objaviti tehnologiju koja može skenirati sve slike koje su korisnici pohranili u iCloud i identificirati fotografije koje sadrže seksualno zlostavljanje djece. Materijal seksualnog zlostavljanja djece (CSAM).

Ovu će tehnologiju Apple lansirati krajem ove godine, najvjerojatnije u pilot verziji, za ograničeni broj korisnika.

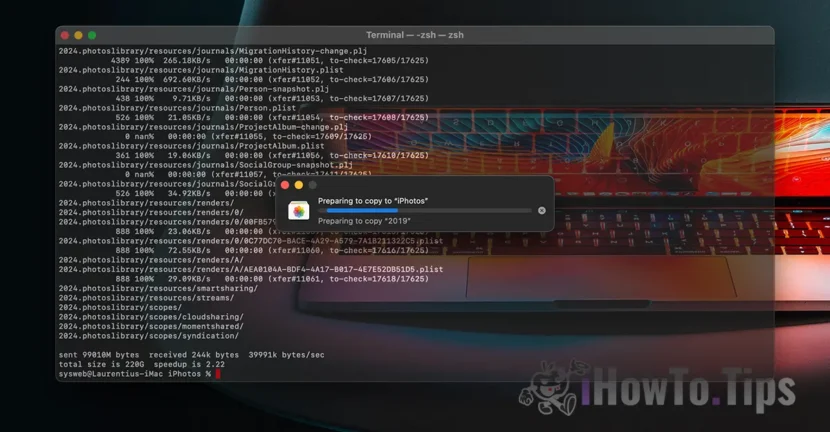

Ako se pitate "gdje je povjerljivost podataka?", saznajte da je sve što dobijemo sadržaj videozapisi/fotografije to se radi putem šifriranog protokola. Na isti način, pohrana podataka u iCloudu je kriptirana, ali pružatelji takvih usluga drže ključ za enkripciju podataka. Ovdje ne govorimo samo o Appleu. Microsoft, Google i drugi servisi za pohranu podataka u oblaku rade isto.

Pohranjeni podaci mogu se dekriptirati i provjeriti ako se zahtijevaju u pravnom postupku ili ako flagrantno krše zakone. Kao što su oni koji se tiču djela nasilja nad djecom i ženama.

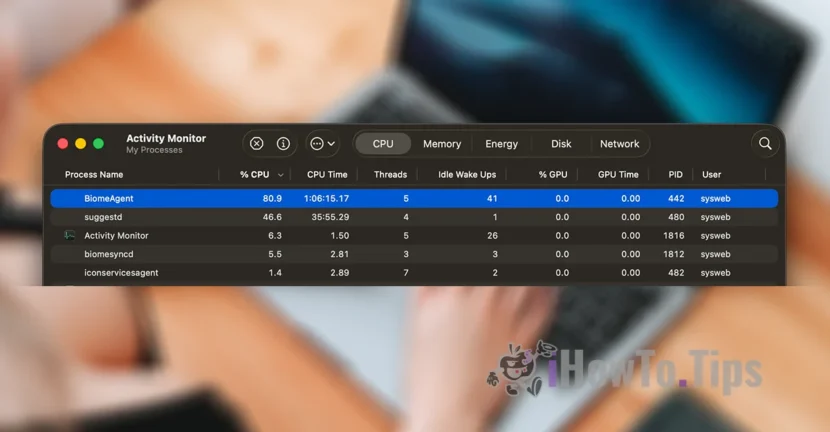

Kako bi očuvala privatnost korisnika, tvrtka se oslanja na novu tehnologiju, nazvanu NeuralHash, koja će skenirati iCloud fotografije i identificirati one koje sadrže nasilje nad djecom, uspoređujući ih s drugim slikama u bazi podataka.

Donekle je sličan prepoznavanju lica ili inteligentnom prepoznavanju predmeta, životinja i drugih elemenata.

Tehnologija će moći skenirati i provjeriti slike koje su snimljene ili prenesene putem iPhone, iPad ili Mac uređaja, čak i ako će biti podvrgnute promjenama.