Det er kjent at Apple bryr seg mye om konfidensialiteten til dataene som går gjennom enhetene i økosystemet og at de er godt beskyttet mot nysgjerrige øyne. Det betyr imidlertid ikke at brukere ikke trenger å adlyde regler knyttet til etikk, moral og hvorfor ikke, menneskelighet.

Apple har annonsert at de snart vil lansere en teknologi som er i stand til å skanne alle bildene som er lagret av brukere i iCloud og identifisere bilder som inneholder seksuelle overgrep mot barn. Materiale for seksuelle overgrep mot barn (CSAM).

Denne teknologien vil bli lansert av Apple mot slutten av dette året, mest sannsynlig i en pilotversjon, for et begrenset antall brukere.

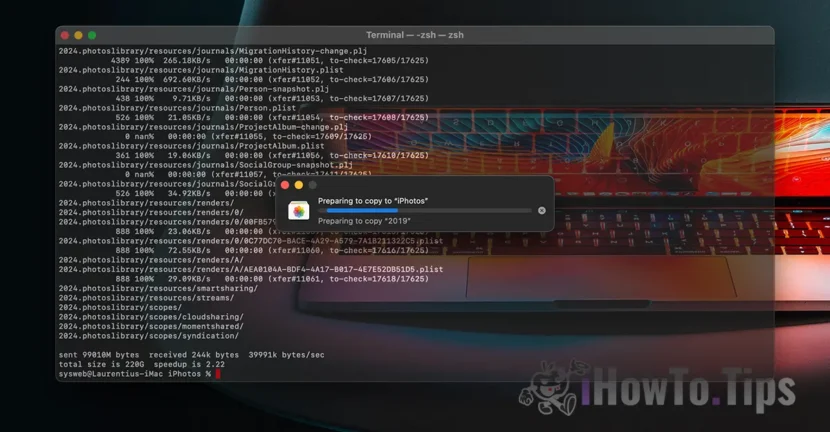

Hvis du spør deg selv "hvor er konfidensialiteten til dataene?", finn ut at alt vi mottar er innhold videoer/bilder det gjøres gjennom en kryptert protokoll. På samme måte er datalagring i iCloud kryptert, men leverandørene av slike tjenester har datakrypteringsnøkkelen. Her snakker vi ikke bare om Apple. Microsoft, Google og andre skydatalagringstjenester gjør det samme.

Datele stocate pot fi decriptate si verificate daca sunt solicitate intr-o actiune legala sau daca incalca flagrant legi. Som for eksempel de som gjelder voldshandlinger mot barn og kvinner.

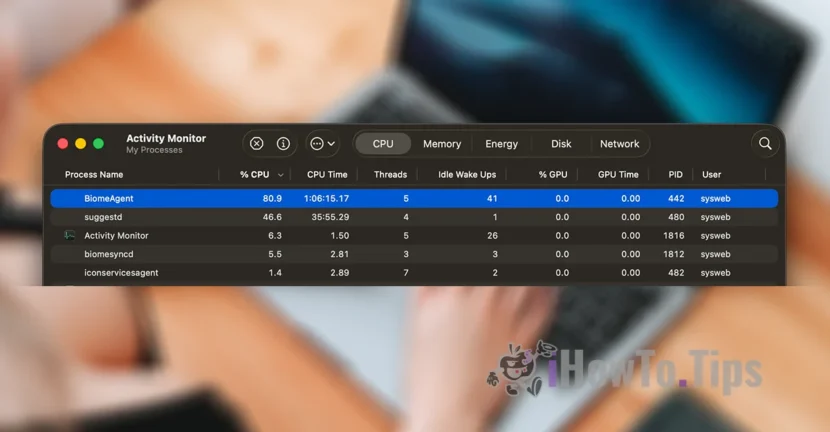

For å bevare brukernes personvern er selskapet avhengig av en ny teknologi, kalt NeuralHash, som skal skanne iCloud-bilder og identifisere de som inneholder vold mot barn, ved å sammenligne dem med andre bilder i en database.

Det ligner litt på ansiktsgjenkjenning eller intelligent gjenkjenning av gjenstander, dyr og andre elementer.

Teknologien vil kunne skanne og verifisere bildene som er tatt eller overført gjennom en iPhone, iPad eller Mac-enhet, selv om de vil gjennomgå endringer.