É sabido que a Apple se preocupa muito com a confidencialidade dos dados que passam pelos dispositivos do ecossistema e que eles estão bem protegidos de olhares indiscretos. Porém, isso não significa que os usuários não devam obedecer a regras relacionadas à ética, à moral e, porque não, à humanidade.

A Apple anunciou que em breve lançará uma tecnologia capaz de escanear todas as imagens armazenadas pelos usuários no iCloud e identificar fotos que contenham abuso sexual contra crianças. Material de abuso sexual infantil (CSAM).

Esta tecnologia será lançada pela Apple no final deste ano, provavelmente em versão piloto, para um número limitado de utilizadores.

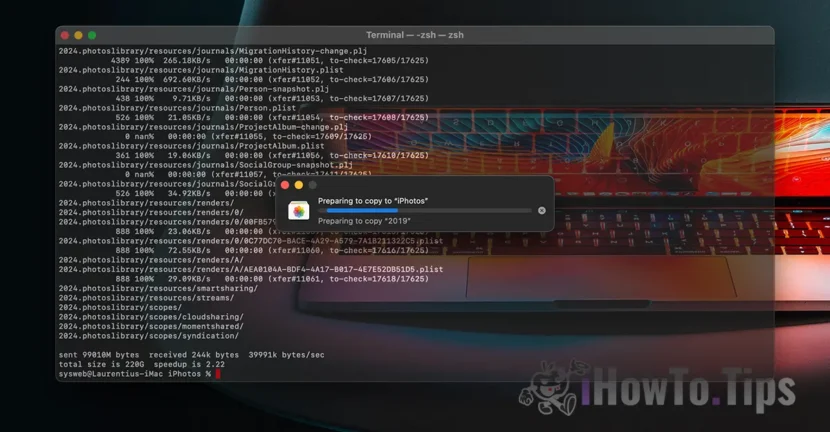

Se você se perguntar “onde está o sigilo dos dados?”, descubra que tudo que recebemos é conteúdo vídeos/fotos isso é feito por meio de um protocolo criptografado. Da mesma forma, o armazenamento de dados no iCloud é criptografado, mas os provedores de tais serviços detêm a chave de criptografia dos dados. Aqui não estamos falando apenas da Apple. Microsoft, Google e outros serviços de armazenamento de dados em nuvem fazem o mesmo.

Os dados armazenados podem ser descriptografados e verificados caso sejam solicitados em uma ação judicial ou se violarem flagrantemente leis. Como aqueles relativos a atos de violência contra crianças e mulheres.

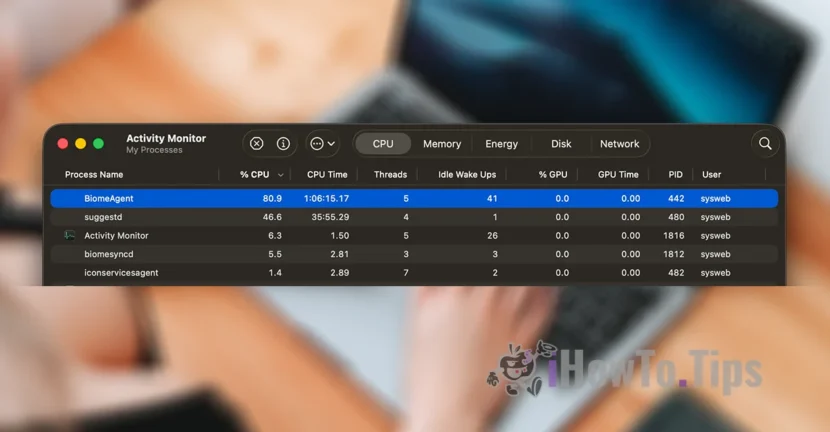

Para preservar a privacidade dos usuários, a empresa conta com uma nova tecnologia, chamada NeuralHash, que irá escanear fotos do iCloud e identificar aquelas que contenham violência contra crianças, comparando-as com outras imagens de um banco de dados.

É um pouco semelhante ao reconhecimento facial ou reconhecimento inteligente de objetos, animais e outros elementos.

A tecnologia será capaz de escanear e verificar as fotos tiradas ou transferidas através de um dispositivo iPhone, iPad ou Mac, mesmo que sofram alterações.